Brain2Music利用思想来再现音乐

传奇石乐队吉他手基思·理查兹曾说过:“音乐是一种语言,不用特定的词语来表达。它用情感来表达,如果它存在于骨子里,那就是骨子里的。”

基思了解音乐,但谷歌和日本大阪大学的研究人员了解大脑活动,他们报告了在重建音乐方面取得的进展,不是从骨头,而是从实验室观察到的人类脑电波。该团队的论文《Brain2Music:ReconstructingMusicfromHumanBrainActivity》于7月20日发布在预印本服务器arXiv上。

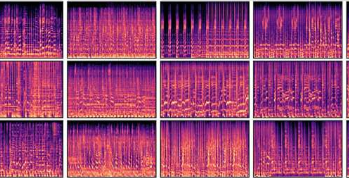

研究人员为五名受试者播放了涵盖摇滚、古典、金属、嘻哈、流行和爵士乐等10种流派的音乐样本,同时观察他们的大脑活动。他们在聆听时记录功能性核磁共振(fMRI)读数。(与MRI读数不同,fMRI读数记录随时间变化的代谢活动。)

然后,这些读数被用来训练一个深度神经网络,该网络可以识别与音乐的各种特征(例如流派、情绪和乐器)相关的活动。

中间步骤将MusicLM纳入研究中。该模型由谷歌设计,根据文本描述生成音乐。与功能磁共振成像一样,它可以测量仪器、节律和情绪等因素。文本输入的一个例子是:“冥想歌曲,平静和舒缓,有长笛和吉他。音乐缓慢,注重营造一种和平与安宁的感觉。”

研究人员将MusicLM数据库与功能磁共振成像读数联系起来,使他们的人工智能模型能够重建受试者听到的音乐。大脑活动不是文本指令,而是为音乐输出提供背景。

“我们的评估表明,重建的音乐在语义上类似于原始音乐刺激,”谷歌的蒂莫·登克(TimoDenk)说,他是最近论文的几位作者之一。

他们恰当地将他们的人工智能模型命名为Brain2Music。

“生成的音乐在流派、乐器和情绪等语义属性方面类似于人类受试者所经历的音乐刺激,”他说。他们进一步确定了反映来自音乐文本描述的信息的大脑区域。

该团队提供的示例表明,Brain2Music根据受试者的脑电波解释的音乐摘录听起来非常相似。

其中一首采样歌曲是2000年最早的十大热门歌曲之一,布兰妮·斯皮尔斯(BritneySpears)的“Oops!…IDidItAgain”。尽管歌词难以理解,但歌曲的许多音乐元素(例如乐器的声音和节拍)紧密匹配。研究人员解释说,Brain2Go专注于乐器和风格,而不是歌词。

“这项研究是第一个从生物学角度提供定量解释的研究,”登克说。但他承认,尽管文本到音乐模型取得了进步,“但人们对它们的内部过程仍然知之甚少。”

人工智能还没有准备好进入我们的大脑并写出完美编排的曲子——但这一天可能不会太远。

登克说,音乐生成模型的未来工作将改善“重建和刺激之间的时间一致性”。他推测“来自纯粹想象”的音乐作品的更加忠实的再现就在眼前。

也许未来的歌曲作者只需要想象歌曲的合唱,而无线连接到听觉皮层的打印机就会打印出乐谱。贝多芬二十多岁时开始失聪,他为了更好地听到音乐而敲击琴键,毁掉了钢琴。他会从Brain2Music中得到乐趣,并节省不少钢琴。

《Yesterday》的作者保罗·麦卡特尼(PaulMcCartney)在1999年的BBC民意调查中被评选为20世纪最佳歌曲,他曾说过一句著名的话:他在梦中想到了这首歌的想法,但他花了一年半的时间才意识到这一点。填写所有缺失的部分。如果未来的麦卡特尼在午夜梦中想出一个可能风靡全球的作品,那么Brain2Go类型的模型很可能会确保在早餐桌上等待着作者的完整、快速、准确的渲染。

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

-

【木岛法子介绍】木岛法子(Kazuko Kikuchi)是日本著名演员、模特及艺人,以其在影视作品中的出色表现和独特...浏览全文>>

-

【木代尔是什么面料】“木代尔是什么面料”是许多消费者在选购衣物时常常会提出的问题。木代尔是一种天然纤维...浏览全文>>

-

【木代尔和莫代尔哪种面料好】在选择衣物面料时,很多人会遇到“木代尔”和“莫代尔”这两个名称,容易混淆它...浏览全文>>

-

【萝卜的营养价值】萝卜是一种常见的根茎类蔬菜,不仅味道清脆爽口,还具有丰富的营养价值。无论是生吃、炒食...浏览全文>>

-

【萝卜的药用功效和作用】萝卜,作为日常生活中常见的蔬菜之一,不仅味道清脆、营养丰富,还具有多种药用价值...浏览全文>>

-

【萝卜的家常做法】萝卜是一种非常常见的蔬菜,不仅价格实惠,而且营养丰富,适合多种烹饪方式。无论是炖、炒...浏览全文>>

-

【萝卜的功效与作用与主治】萝卜是一种常见的根茎类蔬菜,广泛种植于世界各地,具有丰富的营养价值和多种药用...浏览全文>>

-

【萝卜刀怎么玩儿】“萝卜刀”作为一种近年来在网络上逐渐流行的玩具,因其独特的玩法和趣味性吸引了大量年轻...浏览全文>>

-

【萝卜刀是什么】“萝卜刀”是近年来在网络上迅速走红的一种玩具,因其外形酷似胡萝卜而得名。它不仅是一种简...浏览全文>>

-

【萝卜刀的危害】近年来,“萝卜刀”作为一种新型玩具,因其造型独特、操作简单而受到部分青少年的喜爱。然而...浏览全文>>