DeepMind的PerceiverAR迈向更高AI效率的一步

Transformer核心的自动回归注意力以及类似的程序,变成了扩展的噩梦。DeepMind/谷歌最近的一项工作提出了一种减少此类程序的方法。

人工智能中极其流行的深度学习部分令人担忧的方面之一是程序的规模越来越大。该领域的专家表示,计算任务注定会变得越来越大,因为规模很重要。

越来越大的程序是资源消耗者,这是深度学习社会伦理中的一个重要问题,这一困境引起了《自然》等主流科学期刊的关注。

这就是为什么每次提到效率这个词都很有趣,比如,我们能让这个人工智能程序更有效率吗?

DeepMind和谷歌大脑部门的科学家最近对他们去年推出的神经网络Perceiver进行了改造,以使其在计算能力需求方面更加高效。

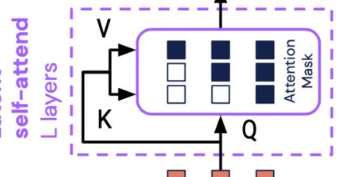

新程序PerceiverAR以越来越多的深度学习程序的“自回归”方面命名。自回归是一种让机器将其输出用作程序新输入的技术,这是一种递归操作,可形成多个元素如何相互关联的注意力图。

另外:Google的超级模型:DeepMindPerceiver是通向可以处理任何事物的AI机器的道路上的一步

谷歌于2017年推出的广受欢迎的神经网络Transformer具有这种自回归特性。许多模型都这样做了,包括GPT-3和Perceiver的第一个版本。

PerceiverAR是Perceiver的第二个版本,称为PerceiverIO,于3月推出,而原始Perceiver于一年前的本月推出。

原始感知器的创新点是把Transformer拿过来,调整一下,让它以灵活的形式消费各种输入,包括文本声音和图像,而不是局限于特定的一种输入,将各种不同的输入分开。通常开发神经网络。

Perceiver是越来越多的程序之一,它们使用自动回归注意机制来混合不同的输入模式和不同的任务域。其他示例包括Google的Pathways、DeepMind的Gato和Meta的data2vec。

然后,在3月,构建Perceiver的AndrewJaegle及其同事的同一个团队推出了“IO”版本,它增强了Perceiver的输出以适应不仅仅是分类,实现了具有各种结构的大量输出,范围从文本语言输出到光流场到视听序列到符号无序集。它甚至可以在星际争霸II游戏中产生运动。

现在,在使用PerceiverAR进行通用、长上下文自回归建模的论文中,Jaegle和团队面临的问题是,随着模型在多模式输入和输出任务中变得越来越雄心勃勃,它们应该如何扩展。

问题是,Transformer的自回归质量,以及任何其他构建从输入到输出的注意力图的程序,都需要在数十万个元素的分布方面具有巨大的规模。

这就是注意力的致命弱点,准确地说,需要关注任何事情,以便组装形成注意力图的概率分布。

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

-

【木瓜生吃的正确吃法】木瓜是一种营养丰富、口感清甜的水果,不仅适合煮熟食用,也适合生吃。然而,并非所有...浏览全文>>

-

【木瓜奇迹仲夏激情木瓜超帅暝王哪里爆具体点】在《木瓜奇迹》这款游戏中,玩家常常会遇到一些强力角色或装备...浏览全文>>

-

【木瓜奇迹私服积分怎么得】在《木瓜奇迹》这款游戏中,私服(非官方服务器)是玩家自行搭建的服务器,通常会...浏览全文>>

-

【木瓜奇迹49000点召唤怎么加点】在《木瓜奇迹》这款游戏中,玩家达到49000点后,可以解锁“召唤”功能。召唤...浏览全文>>

-

【木瓜可以炖排骨吗】木瓜和排骨的搭配,是很多人在日常烹饪中会尝试的一种组合。虽然这并不是传统意义上的经...浏览全文>>

-

【木瓜酒有什么功效与作用】木瓜酒是一种以木瓜为主要原料酿造而成的饮品,兼具水果的天然营养与酒类的醇香。...浏览全文>>

-

【木瓜红酒汤怎么做】木瓜红酒汤是一道结合了水果与酒类的特色饮品,口感清爽,略带果香与酒香,适合在饭后饮...浏览全文>>

-

【木瓜功效作用与主治】木瓜,学名Chaenomeles sinensis,又称番木瓜、宣木瓜等,是蔷薇科植物的一种。在中医...浏览全文>>

-

【箩组词有哪些】“箩”是一个常见的汉字,通常用于表示一种装东西的工具或容器。在日常生活中,“箩”常与“...浏览全文>>

-

【木瓜根炖排骨的做法】木瓜根炖排骨是一道具有清热解毒、润肺止咳功效的家常汤品,尤其适合秋冬季节食用。它...浏览全文>>